Сайт

Сайт

Категория

GPT-3 Alternative Large Language Models (LLMs)Следующее приложение

Chinchilla by DeepMindCerebras-GPT

Семейство открытых, вычислительно эффективных, больших языковых моделей

О Cerebras-GPT

Cerebras выпустила семь моделей GPT-3, которые варьируются от 111 миллионов до 13 миллиардов параметров. Эти модели были созданы с использованием формулы Чинчилла, что делает их более точными и вычислительно эффективными, чем когда-либо.

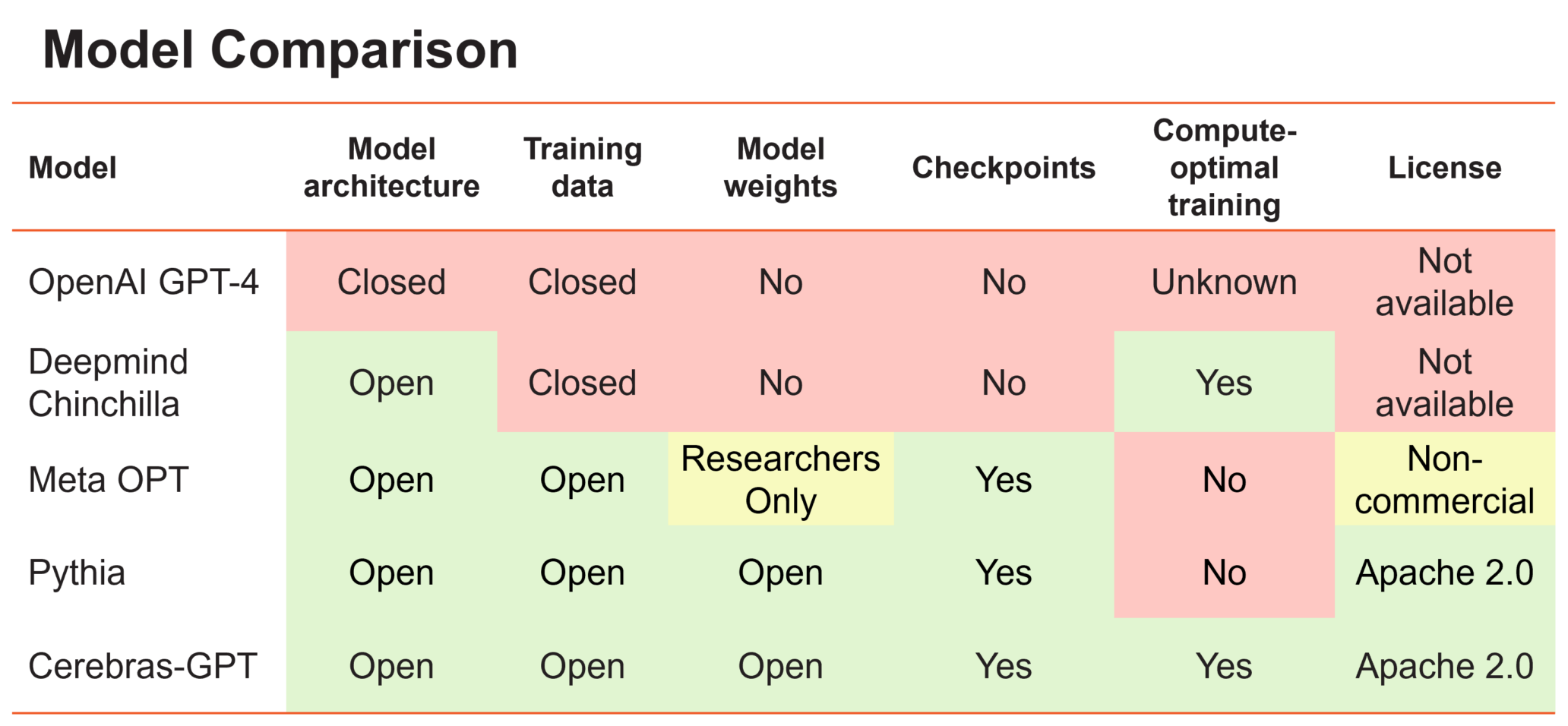

Использование искусственного интеллекта становится все более ограниченным, с выпуском более крупных моделей, таких как GPT4 от OpenAI, без какой-либо информации о архитектуре модели, данных обучения, используемом оборудовании или гиперпараметрах.

Для того чтобы LLM (большие языковые модели) были по-настоящему открытой технологией, важно иметь доступ к моделям с открытым исходным кодом, воспроизводимым и без лицензионных сборов как для научных, так и для коммерческих применений. В этой связи Cerebras создала серию моделей-трансформеров под названием Cerebras-GPT, которые являются открытыми и выпущены под лицензией Apache 2.0.

Cerebras обучила GPT-3, используя оптимальное расписание вычислений и оптимальное масштабирование, указанные Чинчиллой и μ-параметризацией, превосходящими существующие клонированные модели GPT-3. Впервые μ-параметризация была использована в производственной среде. Эти модели были обучены с нуля, что означает, что сообщество больше не должно полагаться на LLaMA (анализ больших языковых моделей).

Скриншоты Cerebras-GPT

Читать на английском

Все о GPT-3

Все о GPT-3